محققان اطلاعات کوانتومی را از طریق شبکه کوانتومی انتقال میدهند

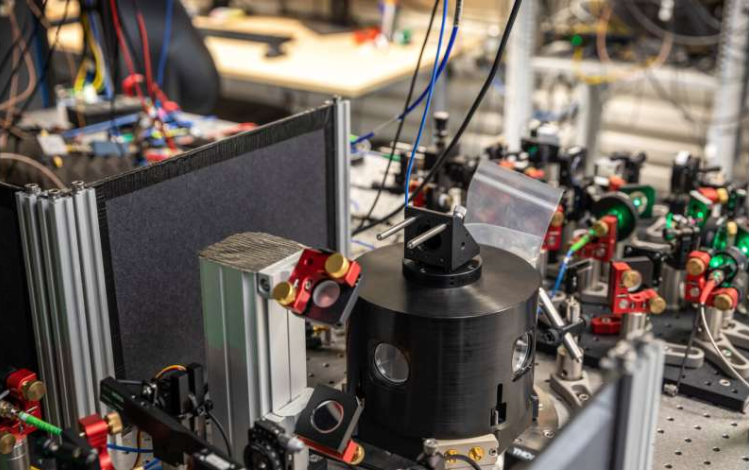

محققان در دانشگاه «دلفت» هلند موفق به انتقال اطلاعات کوانتومی با استفاده از یک شبکه کوانتومی ساده شدند. این موفقیت در نوع خود گام مهمی به سوی اینترنت کوانتومی است.

محققان دانشگاه دلفت و مرکز تحقیقات علمی کاربردی «TNO» هلند، یافتههای خود را در مجله «Nature» به چاپ رساندند.

شبکه کوانتومی نوعی شبکه متشکل از گرههای متعدد است که میتواند اطلاعات را در قالب بیتهای کوانتومی که «کیوبیت» نیز نامیده میشوند، بین پردازندههای کوانتومی جابجا کند.

قدرت اینترنت کوانتومی که محققان در تلاش برای گسترش آن هستند، به توانایی ارسال داده میان گرههای شبکه بستگی دارد.

استفاده از شبکههای کوانتومی برای جابجایی اطلاعات امکان به اشتراکگذاری امن اطلاعات محرمانه، اتصال چندین کامپیوتر کوانتومی به یکدیگر برای افزایش توانایی محاسباتی و امکان استفاده از حسگرهای کوانتومی بسیار دقیق را فراهم میآورد.

ارسال اطلاعات کوانتومی

گرههای شبکههای کوانتومی شامل پردازندههای کوانتومی است. ارسال اطلاعات میان این پردازندهها کار دشواری است. یک امکان ارسال بیتهای کوانتومی استفاده از ذرات نور است، اما به دلیل تلفات اجتناب ناپذیر فیبرهای نوری به ویژه در فواصل طولانی، ذرات نور به احتمال زیاد به مقصد نخواهند رسید. از آنجایی که اساسا کپی کردن بیتهای کوانتومی غیرممکن است، از دست دادن یک ذره نور بدین معناست که اطلاعات به طور غیرقابل جبرانی از بین میروند.

اکنون محققان نشان دادهاند که امکان انتقال اطلاعات میان دو گره مجاور وجود دارد. در این روش میان گرههای شبکه یک حالت درهم تنیده ایجاد میشود تا اطلاعات انتقال یابند. این درهم تنیدگی در هر لحظه میان جفت شبکهها برقرار میشود تا درنهایت اطلاعات بتواند گسترش یابد.

محققان این آزمایش را برای مقادیر مختلف بیت کوانتومی تکرار کردند و دریافتند ویژگی عجیب دنیای کوانتوم در این جا نیز بروز پیدا میکند: دادهها روی یک گره ناپدید میشوند و بلافاصله در گره بعدی ظاهر میشود.

دانشمندان تلاش دارند در مراحل بعدی تحقیقات خود، انتقال اطلاعات را به صورت معکوس نیز انجام دهند.